Numerisk vejrudsigt

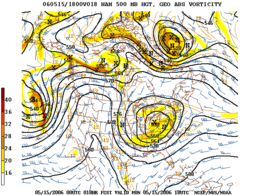

Numerisk vejrudsigt Eksempel på kortudgang med sorte konturer af isohypser af højden af det geopotentielle tryk på 500 hPa ved hjælp af en numerisk forudsigelsesmodel

Eksempel på kortudgang med sorte konturer af isohypser af højden af det geopotentielle tryk på 500 hPa ved hjælp af en numerisk forudsigelsesmodel

| Brug | Vejrudsigt |

|---|

Den numeriske vejrforudsigelse (NWP) er en anvendelse af meteorologi og computeren . Det er baseret på valget af matematiske ligninger, der giver en tæt tilnærmelse af den virkelige atmosfæres opførsel . Disse ligninger løses derefter ved hjælp af en computer for at opnå en accelereret simulation af fremtidige tilstande i atmosfæren. Den software, gennemførelse af denne simulering kaldes en numerisk vejr forudsigelse model .

Historisk

Ideen om at bruge digitale modeller til at forudsige det kommende vejr var et vigtigt fremskridt i meteorologiens historie . I 1904 var Vilhelm Bjerknes den første til at foreslå, at forudsigelsen af atmosfærens opførsel kunne behandles som et problem med matematisk fysik, der blev stillet i henhold til de indledende betingelser.

Disciplinen med numerisk vejrudsigter blev grundlagt i 1922 med udgivelsen af bogen Weather Prediction by Numerical Process af den britiske matematiker Lewis Fry Richardson . To årtier før opfindelsen af computeren forestillede Richardson sig at have en hær af menneskelige computere til at løse ligningerne udviklet af Bjerknes numerisk. Det mislykkedes imidlertid på grund af beregningskompleksitet og numerisk ustabilitet forårsaget af iboende fejl i dataene.

I 1928 offentliggjorde Courant , Friedrichs og Lewy et papir om begrænsningerne ved digitalisering af data og numeriske modelligninger for at undgå disse ustabiliteter. Richardsons banebrydende vision begyndte at bære frugt i 1950, da Charney , Fjørtoft (in) og von Neumann efterfulgte den første NWP på en computer, ENIAC , ved hjælp af en model barotrop enkel. Den første operationelle prognose er fra 1954 af det svenske institut for meteorologi og hydrologi takket være Carl-Gustaf Rossbys team . De første mere komplekse operationelle numeriske prognoseprogrammer blev udviklet i begyndelsen af 1960'erne ved hjælp af en multilevel og baroklinisk atmosfære . Udviklingen var oprindeligt langsommere til objektiv analyse end til prognoser på grund af manglen på data om oceaner og ørkenområder, men situationen har ændret sig med integrationen af data fra meteorologiske satellitter siden 1990'erne.

I nærværelse af en stærk efterspørgsel efter vejrudsigter inden for mange aktivitetsområder har disciplinen fortsat udviklet sig siden da understøttet af stigningen i computerkraft og drevet af enorme teoretiske fremskridt inden for numeriske metoder og inden for meteorologi.

Anvendelser

- I operationel meteorologi bruges NWP til at lave prognoser, hvis rå numeriske resultater vil gennemgå forskellige former for efterbehandling for at gøre dem brugbare. Resultaterne behandles af anden software eller fortolkes af meteorologer for at imødekomme specifikke brugerbehov. Dette inkluderer offentlig vejrudsigt og applikationer inden for et stort antal aktivitetsområder såsom transport , landbrug , katastrofebegrænsning osv.

- Numeriske prognoseresultater bruges til at drive andre specialiserede modeller. Disse kan for eksempel være modeller for spredning og bane af atmosfæriske forurenende stoffer eller atmosfæriske kemimodeller til forudsigelse af luftkvalitet (især forudsigelse af smog ).

- PNT kan i forskningen bruges til at lave casestudier i "isolation", til at studere en facet eller en bestemt opførsel af atmosfæren eller til at teste forbedringer af modellen i henhold til teoretiske eller praktiske tilfælde, som vi kender til. resultater. PNT-modellen bliver således et virtuelt laboratorium til at studere atmosfæren og forbedre prognoser.

- NWP-modeller kan også bruges til klimaprognoser . Vi er så interesserede i prognosens gennemsnitlige opførsel over en lang periode og ikke længere i at forudsige specifikke begivenheder. Ved at ændre aspekter af prognosen, såsom stigningen i kuldioxid, hjælper klimaforudsigelsesmodeller med at formulere scenarier om konsekvenserne af klimaændringer. Undersøgelsen af disse scenarier hjælper med at guide offentligheden og beslutningstagere i lyset af den globale opvarmning .

Matematisk tilgang

I fysik og teknik, den klassiske fremgangsmåde til opnåelse af ligninger med prædiktiv værdi er at løse en eller flere differentialligninger indeholdende tid variabel . I de mest praktiske tilfælde udtrykker løsningen de variabler, der skal forudsiges, som en funktion af tid og startbetingelser (værdierne af variablerne på det valgte tidspunkt til start af prognosen). Det er så tilstrækkeligt at fodre denne ligning med de numeriske værdier, der kræves for at opnå en såkaldt nøjagtig løsning . Den harmoniske oscillator er et eksempel på et klassisk problem, der egner sig godt til denne tilgang.

Problemet med atmosfærens fremtidige opførsel er meget mere kompleks og har kun en nøjagtig løsning i nogle få meget begrænsede teoretiske undergrupper. For at løse ligningerne af NWP i den virkelige verden er det nødvendigt at bruge metoderne til numerisk analyse . Disse metoder gør det muligt at omformulere ligningerne af atmosfærisk adfærd for at være i stand til at løse dem ved talrige gentagelser af rå numeriske beregninger. På denne måde forløber atmosfærens tilstand i modellen fra et startpunkt til det ønskede prognoseinterval.

Ulempen ved disse numeriske metoder er, at de kræver en tilnærmelse af kontinuiteten af tid og rum på et computernet; simulering bliver således diskontinuerlig i tid og rum. Resultaterne, der er visualiseret i deres beregningsgitter, har et "pixeleret" udseende svarende til et digitalt billede. Ligeledes er tid ikke længere en kontinuerlig variabel, hvor beregninger springer fra et tidstrin til det næste.

Typisk eksempel: En af de operationelle konfigurationer af Environment Canadas GEM-model (fra 2005 ) opdeler rummet i Nordamerika og tilstødende farvande i 15 km firkantede fliser. Størrelsen på disse fliser definerer modelens vandrette opløsning eller maskestørrelse . Derudover repræsenterer modellen den lodrette dimension af atmosfæren ved at opdele den i 58 niveauer. Og endelig fremskynder hver runde af modelberegninger prognosen med 450 sekunder. Modeltidsintervallet mellem beregningsrunderne kaldes tidstrinnet .

Som hovedregel er det ønskeligt at sikre, at mønsteret har det fineste mesh mulig. Dette øger modellens realisme og minimerer akkumuleringen af små beregningsfejl, der er forbundet med numeriske analysemetoder. Derudover er der for en given opløsning et maksimalt tidstrin, kaldet Current-Friedrich-Levy-tilstanden (eller CFL-tilstand), som ikke bør overskrides for at bevare stabiliteten og realismen i de numeriske resultater.

Sub-mesh parametrisering

For at opnå en god prognose er det også nødvendigt at tage højde for fænomener, der er mindre end opløsningens opløsning (såkaldte sub-mesh fænomener ). For eksempel er et tordenvejr betydeligt mindre end masken på de fleste modeller i fuld skala; taget isoleret, havde vi råd til at forsømme det i sammenhæng med en prognose i målestok for et land eller et kontinent. Men et tordenvejrsområde, herunder mange tordenvejr i et stort geografisk område, vil have en betydelig indflydelse på forløbet af den begivenhed, der er genstand for prognosen, gennem produktion af en mærkbar mængde regn og dens effekt i prognosen. balance i atmosfæren. Mere grundlæggende stadig: overlades det til sig selv, at modellen kunne skabe tordenvejr, hvis vandrette størrelse ville svare til modelnettet, hvilket er fuldstændig urealistisk og brutalt vil fordreje prognosen. Vi skal derfor give tordenvejr en implicit eksistens inden for modellen for at sprede den konvektive energi under overholdelse af skalaens overvejelser.

Repræsentationen af den mellemstore til store indflydelse af fænomener i lille skala kaldes parametrisering . De mest parametriserede sub-mesh fænomener af modeldesignere er:

- Den atmosfæriske konvektion lodret (som inkluderer storme)

- De sky fysik ( kondens , indsamlings- og kollision af dråber, Bergeron effekt , skifter fase , etc.)

- Atmosfæriske strålingseffekter (varmestråling)

- Overflade-luft-grænsefladen:

- Udveksling af varme og fugt mellem overfladen og atmosfæren

- Friktion og turbulens nær jorden

- Effekten af bjerge og ujævnt terræn:

- Vindblokerende effekt

- Atmosfæriske bølger nedstrøms fra bjergene

Parameteriseringen af de fysiske fænomener kompenserer ikke fuldstændigt for de begrænsninger, der pålægges af en for stor afstand af modellernes maske. Valg og justering af parametriseringsordninger har en betydelig indflydelse på kvaliteten af prognoser.

Geografisk dækning og prognoseinterval

For at imødekomme øjeblikkelige vejrudsigtsbehov skal der opnås et acceptabelt kompromis for at maksimere modelens rumtemporale opløsning under hensyntagen til:

- det ønskede prognoseinterval (48 timer, ti dage, tre måneder?)

- størrelsen på det forventede geografiske domæne (land, kontinent, verden?)

- produktionsfrister og krav til pålidelighed

- IT, økonomiske og menneskelige ressourcer til rådighed

For kortsigtede prognoser er atmosfærens tilstand i fjerntliggende områder irrelevant. En nuværende forstyrrelse i Amerika vil tage et par dage at sprede sig og få indflydelse på Europa . Vi kan derefter vælge at koncentrere en fin mesh zone af modellen på regionen af interesse og derved forsømme fjerne fænomener. Vi taler om en regional model .

For langsigtede prognoser, f.eks. Ud over to eller tre dage, bliver det nødvendigt at øge modelens dækning til en komplet halvkugle eller endda til hele kloden for korrekt at kunne håndtere de stadig fjerne fænomener, der vil forplante sig. område af interesse. Af samme grund er modelens mesh fordelt ensartet over kloden. Da halvkugleformede modeller er gået i brug, falder denne type prognose til den globale model eller den globale model .

IT-overvejelserI teorien øger opløsningen af modellen realismen og reducerer behovet for parametrisering; dette kan dog kun gøres til betydelige it- og økonomiske omkostninger, især hvis prognosen skal opnås inden for stramme frister.

Eksempel: Hvis den geografiske opløsning for en given model fordobles, stiger antallet af point i beregningsgitteret med en faktor 8; og hvis samtidig trin reduceres med halvdelen (derved fordobler den tidsmæssige opløsning), bliver prognosen derfor 16 gange dyrere af computeren end den tidligere version af modellen. For at håndtere dette problem er det ikke nok at multiplicere den rå computerkraft, fordi aspekter af input-output og datalagring skal tages i betragtning: mængden af data, der skal overføres under beregninger og under lagring af resultaterne øges også af samme faktor. I / O-operationer, som er en flaskehals i enhver form for computer, kan blive en alvorlig hindring for at øge opløsningen på PNT-modeller.

ForudsigelighedDen forudsigelighed er grænsen for evnen til numerisk forudsige fremtidige tilstande af atmosfæren ved hjælp af et netværk overvågning givet. Det defineres sædvanligvis af den tidsramme, inden for hvilken det forventede rodfelt for en forudsagt felt kan forventes at være mindre end forskellen mellem den gennemsnitlige firkant mellem to observerede tilfældige atmosfæriske tilstande. I praksis resulterer dette i stabiliteten af løsningen af prognosen ad gangen X med de tilgængelige data, idet de kender deres iboende fejl og deres rumlige fordeling, hvis der introduceres en lille variation af værdierne i disse data. Det øjeblik, hvor løsningen begynder at afvige mellem beregningerne fra de forskellige forstyrrelser, bliver grænsen for forudsigelighed for vejrsystemet.

Fejlkilder

- Indledende data: måle- og analysefejl

- Datadækning: typisk dårligere i havene og i tyndt befolkede eller økonomisk dårligt stillede områder

- Fejl iboende i de vedtagne numeriske beregningsmetoder

- Fejl forårsaget af modelens maske: Jo grovere masken er, jo mindre passende er modellen til at repræsentere mellemstore og små skala fænomener

- Parameteriseringsfejl

Selv en perfekt model (fri for de sidste tre fejlkilder) kunne ikke producere en perfekt prognose, fordi fejlene under de oprindelige forhold vil stige under prognosen, og prognosen vil afvige fra virkeligheden.

Det er derfor nødvendigt at kende atmosfærens oprindelige tilstand så nøjagtigt som muligt. Videnskaben om at bestemme denne tilstand, kaldet dataassimilering , er i sig selv en stor videnskabelig udfordring, der kræver matematiske og beregningsmæssige ressourcer, der kan sammenlignes med dem, der er afsat til at forudsige sig selv. Datakilderne er forskellige, traditionelt sammensat af overfladeobservationer, hvortil føjes data fra radiosonde , vindprofil og målinger foretaget af kommercielle fly. I øjeblikket satellitmålinger repræsenterer den vigtigste datakilde, og for nylig, refleksionsevner og radar radiale hastigheder er også taget i betragtning i nogle mesoskala modeller .

Imidlertid er brugen af observationsdata alene ikke tilstrækkelig. På den ene side er antallet af variabler i en digital model større end antallet af observationer, på den anden side vil en analyse udført direkte ved interpolering af observationer føre til ustabil opførsel af modellen. Dette er en af grundene til, at Richardsons første forsøg på at modellere atmosfærens opførsel mislykkedes .

For at konstruere analysen bruger vi derfor et udkast kaldet testfeltet , det vil sige en tidligere prognose, generelt 6 eller 12 timer tidligere. Denne oversigt rettes derefter for at passe så tæt som muligt på observationerne, generelt under hensyntagen til observationsfejl. Den mest anvendte tilgang i dag bruger metoderne til beregning af variationer til at bestemme det bedste kompromis mellem kladden og observationerne under hensyntagen til deres respektive fejl. Denne tilgang er betegnet med udtrykket " 3D-Var ", når det kun tager højde for modelens tilstand og de gyldige observationer på tidspunktet for analysen, og " 4D-Var ", når det også tager højde for udviklingen af disse over et tidsvindue.

Ensemble prognoser

I de tidlige årtier med numerisk vejrudsigter krævede beregningsmæssige begrænsninger at køre en model med den højest mulige opløsning og vedtage den resulterende prognose uden ændring. Denne tilgang antager implicit, at hvis de oprindelige betingelser var kendt perfekt, og selve modellen var perfekt, ville den efterfølgende prognose perfekt simulere atmosfærens fremtidige opførsel. Vi kalder denne tilgang deterministisk .

I praksis er hverken observationer eller analyser eller modellen perfekte. Derudover er atmosfærisk dynamik meget følsom, under visse betingelser, for den mindste udsving. En ny sandsynlig tilgang er derfor blevet udviklet af forskere som Edward S. Epstein , ensembleprognoser . Ensembleprognoser ofrer opløsning, så det kan afsætte databehandlingsressourcer til at køre mange kopier af modeller samtidigt i samme prognosetilfælde. I begge tilfælde foretages analysen bevidst lidt anderledes end de andre medlemmer af sættet inden for de iboende usikkerheder ved måling eller analyse. De mere eller mindre divergerende scenarier fra de prognoser, der tilbydes af medlemmerne af ensemblet, gør det muligt at kvantificere atmosfærens forudsigelighed og tilbyde en statistisk fejlmargin på prognosen. Udfordringen ved designet af et sådant system er at sikre, at udsvingene i det udgør et signal, der er repræsentativt for den naturlige usikkerhed ved atmosfærisk dynamik.

Nogle ensemble forudsigelsessystemer (EPS) varierer også metoderne til at parametrere ensemblets medlemsmodeller, så en del af udsvingene i prognoserne repræsenterer modelleringsusikkerheden. Ligeledes er der en stærk interesse for forskningsfællesskabet for forudsigelse af ensemblet i multimodelsæt (dvs. at kombinere modeller med forskellige designs) og sammenlægningen af SPE fra forskellige lande i et super-sæt. Der er i øjeblikket ( 2006 ) to konkrete bestræbelser i denne retning, nemlig det Nordamerikanske Ensemble Prediction System (NAESP) (Canada, De Forenede Stater, Mexico) og THORPEX Interactive Grand Global Ensemble (TIGGE, under koordinering af Verdens Meteorologiske Organisation ) .

Operationel tilgang

Implementeringen af NWP med henblik på operationel vejrprognose (i modsætning til ren forskning) involverer altid følgende trin, hvis implementering kan variere noget afhængigt af placeringen og anvendelsesforholdene:

- Indsamling af meteorologiske observationsdata (fra landstationer, skibe, fly, radioprober, satellitdata fra fjernmålinger osv.)

- Afkodning og kvalitetskontrol af observationer;

- Analyse (udvikling af en digital repræsentation af atmosfærens tilstand i starten af prognosen);

- Lancering af prognosemodellen med analysen som udgangspunkt;

- Efterbehandling af modeloutput: produktion af billeder, bulletiner, anvendelse af statistiske prognosemetoder, menneskelig fortolkning;

- Fremsendelse af prognosen til brugerne i en form, der kan anvendes til at støtte forskellige aktiviteter (landbrug, transport, sundhed, miljøprognoser, økonomisk planlægning osv.)

- Verifikation af efterfølgende prognoser og evaluering af modelens ydeevne.

Eksempel fra Frankrig

Météo-France bruger i øjeblikket to digitale modeller, såsom to kasser, der er indlejret i hinanden for at udstede sine bulletiner. Den globale Arpège- model (Small-scale / large-scale research action) producerer prognoser over hele verden med et strakt maske med en vandret opløsning på ca. 5 km over fastlandet Frankrig og ca. 24 km ved antipoderne.

Siden 2008 har Arome- modellen (anvendelse af forskning på operationer i mesoscale) lavet prognoser over et begrænset domæne inklusive Frankrig med en maske på 2,5 km i starten og 1,3 km siden 2015. Beregningen integrerer og justerer hver time prognoser baseret på om information fra meteorologiske stationer, skibe, bøjer, fly, radar, satellitter osv. Modellen vurderer også pålideligheden af prognosen.

Hovedapplikationscentre

Selvom der er en bemærkelsesværdig vækst i anvendelsen af PNT med relativt beskedne midler, kræver avanceret PNT en betydelig it-infrastruktur, som placerer den blandt de store udfordringer ved moderne computing. Implementeringen af PNT er generelt overdraget til statslige eller endog supra-statslige organisationer. Verdensledere inden for PNT er i øjeblikket (i alfabetisk rækkefølge):

- den Tyskland ( DWD );

- Den Canada ( Canadian meteorologiske center );

- det europæiske center for mellemvejr vejrudsigter (konsortium af europæiske nationer)

- De Forenede Stater ( Nationale centre for miljøforudsigelse (civil), Fleet Numerical Meteorology and Oceanography Center (en) (militær));

- den Frankrig ( Météo-France );

- det japanske ( Japans meteorologiske agentur )

- Det Forenede Kongerige (UK Met Office ).

Det skal bemærkes, at de store operatører af NWP-centre ud over at tilbyde vejrprognosetjenester også udgør en vigtig del af videnskabelig forskning inden for området. Igen har infrastrukturproblemer noget at gøre med det: supercomputeren er i det væsentlige laboratoriet for PNT-forskeren. Derudover hjælper nærheden til forskning og operationer med at fremskynde den teknologiske overførsel af videnskabelige innovationer.

Noter og referencer

- Katia Chancibault, "Numerisk vejrudsigt" (version af 3. marts 2016 på Internetarkivet ) , Laboratorium for studier af overførsler i hydrologi og miljø (LTHE)

- (i) Vilhelm Bjerknes, " Problemet med vejrudsigter, betragtes fra theviewpoints af mekanik og fysik " , Meteorologische Zeitschrift , researh Gate flyvning. 18, nr . 6,december 2009( DOI 10,1127 / 0941-2948 / 2009/416 , læse online , adgang 1 st april 2021 ) "Oversættelse af den originale artikel fra 1904 til tysk" .

- Working Group on the Use of Modern Techniques in Aviation Meteorology, Interpretation Techniques for Numerical Weather Prediction Products for Aviation Meteorology , Vol. 195, Verdens meteorologiske organisation , koll. "Tekniske noter",1994, 112 s. ( læs online ) , kap. 1.1 ("Historik om numerisk vejrforudsigelse").

- (i) Kristine Harper , Louis W. Uccellini , Eugenia Kalnay Kenneth Carey og Lauren Morone , " 2007: 50 års jubilæum af det Operative Numerisk Weather Prediction " , Bulletin of American Meteorological Society , vol. 88, nr . 5,Maj 2007, s. 639–650 ( DOI 10.1175 / BAMS-88-5-639 , Bibcode 2007BAMS ... 88..639H ).

- MALARDEL Sylvie, " Vejrudsigtsmodeller " , på Encyclopedia of the environment ,2019(adgang til 26. november 2019 )

- Verdens meteorologiske organisation , " forudsigelighed " , meteorologisk ordliste på Eumetcal (adgang til 30. november 2013 )

- Hélène Côté, “ Hvad er genanalyser? » , Ofte stillede spørgsmål , konsortium om regional klimatologi og tilpasning til klimaændringer (Ouranos) (adgang 14. september 2015 )

- (i) Peter Lynch Met Éiriann, " Richardson prognose: Hvad gik galt? " [PDF] , NOAA,Juni 2004 - En analyse af Richardsons første forudsigelses essay.

- Azar Khalatbari , " Hundrede gange mere præcist vejr ", Sciences et Avenir , nr . 725,Juli 2007( læs online ).

Se også

Bibliografi

- Sylvie Malardel, Fundamentals of Meteorologi - 2 nd edition: På skolen tid , Toulouse, Cépaduès,2009, 711 s. ( ISBN 978-2-85428-851-3 )

- (en) Hagos S og LR Leung, " Storskala miljøvariabler og overgang til dyb konvektion i skyopløsende model-simuleringer: En vektorrepræsentation " , Journal of Advances in Modelling Earth Systems , bind. 4, n o M11001,2012( DOI 10.1029 / 2012MS000155 )

Relaterede artikler

- Primitive atmosfæriske ligninger

- Antal strøm

- Climateprediction.net

- Lewis yngel richardson

- Odon Godart

- André Robert

- Kvantitativ prognose for nedbør

- GRIB- format til formidling af modeldata

eksterne links

- Canadian Meteorological Center , “ Forklaring til TFN, ” Canadas regering .

- "Numerisk vejrudsigt" (version af 3. marts 2016 på internetarkivet ) , Euromet.

- " Vejrudsigt " , Météo Frankrig .

- " COSMO-prognosesystemet " , MeteoSwiss .

- (da) Wilhelm Bjerknes, "Problemet med vejrforudsigelse, set fra standpunkterne inden for mekanik og fysik" (version af 14. juni 2020 på internetarkivet ) , NOAA .

- Katia Chancibault, " Numerisk vejrudsigt " [ arkiv du3. marts 2016] [PDF] , hydro-meteorologiske risici, oversvømmelser og oversvømmelser , laboratorium for studier af overførsler i hydrologi og miljø (LTHE) (hørt 31. marts 2021 ) .

- (fr) Peter Lynch, Met Éireann , ” Richardsons prognose: Hvad gik galt? (En analyse af Richardsons første forudsigelsestest) ” [PDF] , National Oceanic and Atmospheric Administration (NOAA),Juni 2004(tilgængelige på en st april 2021 ) .